Hallo zusammen, ich ergreife einfach mal die Gelegenheit den aktuellen Stand des Portals zu beschrieben, sowie was so in nächster und ferner Zukunft geplant ist, und wann wir endlich wieder Daten hochladen können.

Wie weit ist die Software?

Kurzfassung: Nicht weit. Mit dem Rewrite der Anwendung habe ich hauptsächlich Technologien umgestellt, sodass wir in Zukunft mit mehr Leuten daran arbeiten können. Jetzt ist das Portal auch wirklich „unser Code“, davor war es ziemlich zusammengestückelt aus anderen Projekte usw…

Die größte und wichtigste Änderung daran ist, dass die Python-Skripte („FACE“) nun vom Portal verwendet werden, um die Daten zu interpretieren und zu verarbeiten, und nicht eine eigene, getrennte, und in JavaScript implementierte Fassung der „gleichen“ Logik.

Mehr ist leider noch nicht da. Das heißt aber auch, dass ihr euch alle gern einbringen könnt.

Was steht in nächster Zeit an?

Prinzipiell hauptsächlich Datenverarbeitung, hier fehlt vor allem ein gutes Konzept. Dann ein paar Features, die wir einfach brauchen, um nicht bei steigenden Userzahlen sofort zusammenzubrechen.

- Allgemeines Konzept der Datenverarbeitungs-Pipeline. Es gibt jetzt einen „Worker“ der Verarbeitungsjobs entgegennimmt, und so im Hintergrund z.B. die Tracks importiert. Da fehlt aber dann noch die Anonymisierung und Aggregation. Wann und in was für Einzelschritten das passiert (insbesondere damit nicht immer alles von vorn berechnet werden muss, wenn irgendwer einen Track hochlädt) sollten wir mal gut definieren und dann umsetzen.

-

obs-facesollte mal optimiert werden, dass es schneller rechnet. Vielleicht mitnumpyoder so, nicht jeden Punkt einzeln ausrechnen. - Privacy Zones / Privacy Settings: Wir sollten dem Portal bald beibringen, das gut konfigurierbar zu haben und auch anzuwenden.

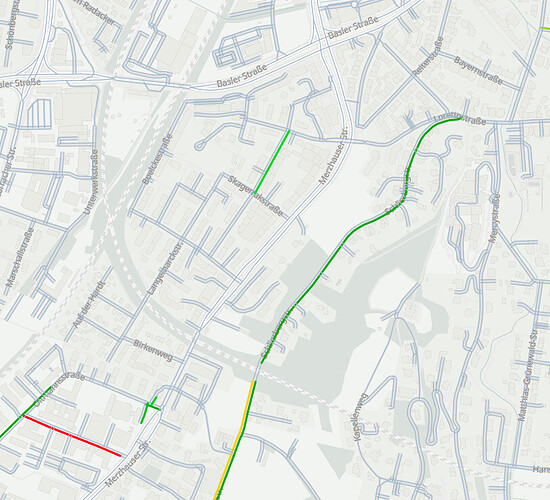

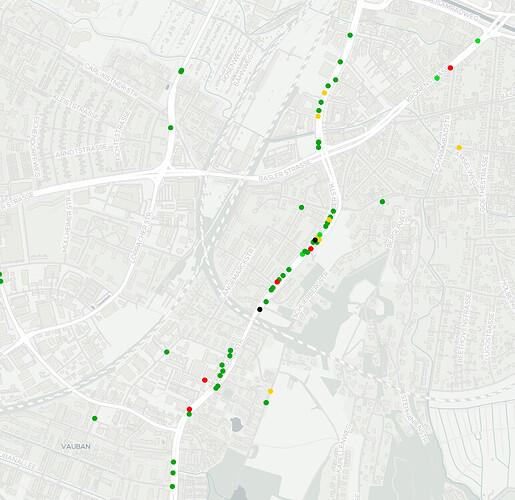

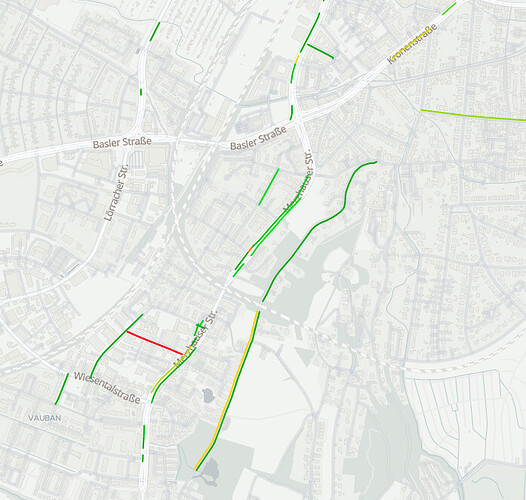

- Und wenn jemand richtig Bock hat die visulaisierung auf irgendein richtiges GIS umzustellen, damit wir die Maps kacheln können und eine schön performante globale Kartenvisualisierung erstellen können – das wäre ein ziemlich alleinstehendes Projekt und sehr kompliziert glaube ich, aber auch seeeehr cool, so langfristig.

- Und nicht zu vergessen, müssen wir etwas „Housekeeping“ machen, inbesondere wäre es schön, Migrationen schreiben zu können. Da jetzt alle schon viele Installationen exisiteren, und Leute ihre Tracks hochladen, wird eine Lösung dafür langsam Zeit

Wie kann ich helfen?

Schreib doch einfach mal hier, oder in Slack, oder auf Github, dass du helfen möchtest. Die Sommerpause ist vorbei und wir fangen wieder an, die Arbeit zu koordinieren. Los geht’s!

Wo bleibt die „offizielle“ Installation der OpenBikeSensor Community?

Früher oder später werden wir eine stabile „offizielle“ Installation der Portalsoftware anbieten, auf der sich alle einen Account anlegen und dann fleißig Daten hochladen können. Bisher gibt es zwar eine Installation, die ist allerdings in Testbetrieb und wird nicht öffentlich beworben, insbesondere da wir sie jederzeit zurücksetzen können müssen. Außerdem sind wir noch dabei, die datenschutzrechtlichen Details auszuarbeiten. Leider können wir ohne diese nicht starten, und so richtig auskennen tut sich auch niemand.

Wann seid ihr endlich fertig?

Keine Ahnung. Aber wenn du und deine Freund:innen jetzt loslegen wollen, Daten hochzuladen, siehe

Der mittel- und langfristige Plan: Dezentralisierung und Föderation

Diese irgendwann verfügbare „offizielle“ Installation kann von allen genutzt werden, sobald sie fertig wird. Allerdings wünschen wir uns, dass Regional- und Projektgruppen sich ihre eigene Installationen aufsetzen, auch gern jetzt schon. Dabei helfen wir gern. Das Ziel ist, damit die Verantwortung für die Daten zu streuen (Dezentralisierung) und unabhängige Weiterentwicklungen zu ermöglichen (Innovation, yeah!).

Langfristig werden wir der Software dann beibringen, dass die anonymisierten und vorverarbeiteten Daten aus ganz vielen unabhängigen Installationen (die ganzen Regionalgruppen, Projekte, und die „offizielle“ Instanzen) automatisch zusammen in einen großen globalen Datenpool fließen. Bis dahin ist es aber noch ein weiter Weg, und die Schnittstellen dafür sind noch nicht entworfen. Auch hier kann gerne bereits losgearbeitet werden, hauptsächlich erstmal auf konzeptioneller Ebene, bevor es tatsächlich an eine Umsetzung geht.

Ich hoffe, dieser Überblick ist hilfreich, und dass sich jetzt eine Handvoll Leute findet die nach und nach die ganzen schönen Features oben baut. Dann haben wir hoffentlich in ein paar Wochen bis Monaten eine globale Karte die sich täglich updated, und alle können dezentral ihre persönlichen Tracks verwalten.

war, habe ich mal ein endloses HTML5 Canvas gebaut auf dem jeder, ähnlich wie in Paint, malen konnte.

war, habe ich mal ein endloses HTML5 Canvas gebaut auf dem jeder, ähnlich wie in Paint, malen konnte. :D).

:D).

Aber das finden wir auch noch raus.

Aber das finden wir auch noch raus.

).

).