Hier findet ihr einen Testdatensatz mit fast 2000 Überholevents aus der Region Darmstadt-Dieburg (können unter Windows z.B. mit 7zip geöffnet werden, unter Linux mit tar -Jxf extrahiert werden.)

Edit auf @opatut s Anregung hin: Ihr dürft die Daten unter der CC0 Lizenz verwenden. Ab der zweiten Version die ich hochlade, werde ich (falls ich das tue) Versionsnummern vergeben.

Ganz ohne Einarbeitung helfen die Daten natürlich noch nix - für einen Start in die Auswertung braucht es also noch die OpenBikeSensor-Scripts.

Quickstart: Mit folgender Kommandoabfolge kann ich eine erste Auswertung erzeugen (Vorraussetzung: git, python, curl, bash oder ähnliche shell).

# fetch the script

git clone https://github.com/openbikesensor/OpenBikeSensor-Scripts.git

# create virtual environment to not mess up global python packages and install scripts

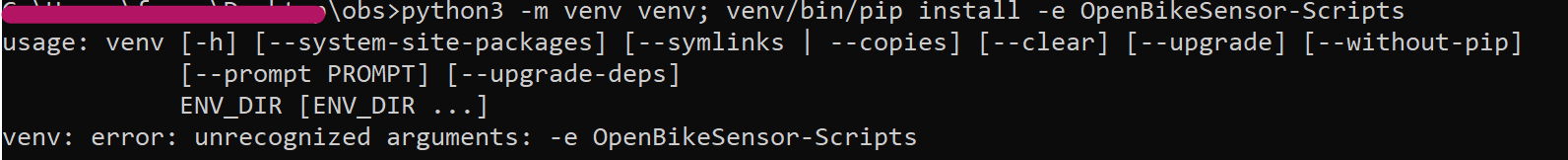

python3 -m venv venv; venv/bin/pip install -e OpenBikeSensor-Scripts

# copy the html stuff to local directory and go there

popd; mkdir local; cp -r OpenBikeSensor-Scripts/visualization local; pushd local

# download example data

curl -O https://xn--grgen-jua.name/datadump.tar.xz

# unpack example data

tar -Jxf datadump.tar.xz

# make subdirectory for analysis results

# analyze data (can take long, may need to run several times if it aborts with errors)

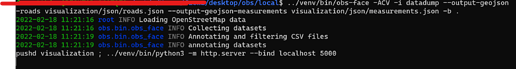

../venv/bin/obs-face -ACV -i datadump --output-geojson-roads visualization/json/roads.json --output-geojson-measurements visualization/json/measurements.json -b .

# run local web server

pushd visualization ; ../venv/bin/python3 -m http.server --bind localhost 5000

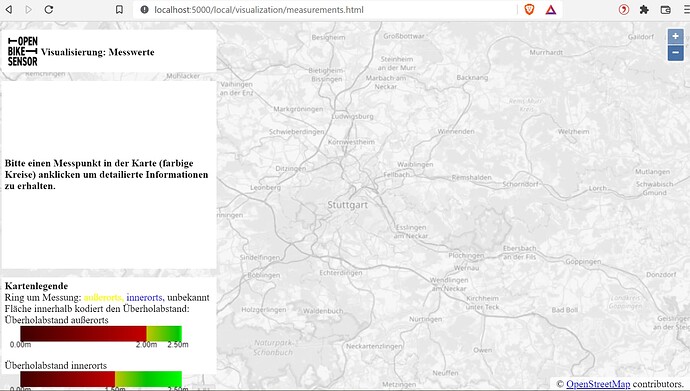

# now browse to http://localhost:5000 and zoom the measurements or roads map to somewhere near Darmstadt (30km south of Frankfurt am Main)

Da die Tracks sich über fast 300 Tiles und 1944 events erstrecken, dauert die Auswertung etwas (20 - 30 Minuten bei mir).

Alternativ können die Daten natürlich auch zum Testen in ein selbstaufgesetztes Portal hochgeladen werden. Oder wenn eine schnellere Auswertung gewünscht ist, kann ein Verzeichnis mit nur ein paar der .csv Dateien aus dem datadump verzeichnis angelegt und ausgewertet werden.

Zum Hintergrund: Als ich angefangen habe, das Portal für den ADFC Darmstadt aufzusetzen, hatten wir noch keine OBSe und keine Daten. Ich habe deshalb mit einem einzelnen Track aus dem damals noch aktiven Slack experimentiert. Aber eigentlich möchte man das Portal und die Datenauswertung ja gern anspielen, bevor das Gerät am Rad hängt - Gerade wenn man als Initiative auch ein Portal betreibt oder wenn man als „Datenbegeisterter“ an den Visualisierungsskripten arbeiten will. Die Rohdaten sind aber sensitive personenbezogene Daten, deshalb kam man bisher nicht leicht an einen Beispieldatensatz. Zusammen mit ein paar freiwilligen habe ich nun einen Beispieldatensatz zusammen, mit dem am Beispiel von Darmstadt auf echten Daten experimentiert werden kann. Ich habe von allen darin enthaltenen Fahrern die Einwilligung bekommen, dass es für sie OK ist, diese Daten zu veröffentlichen, um Einsteigern eine Basis für die Auswertung zu geben.

Und vielleicht den Dateinamen um eine Versionsnummer oder ein Datum erweitern, falls es irgendwann mal ein Update von dir/euch gibt

Und vielleicht den Dateinamen um eine Versionsnummer oder ein Datum erweitern, falls es irgendwann mal ein Update von dir/euch gibt